いつものように ChatGPT をつついて遊んでいたら、それを見ていたパートナーが「そんなことできるんだ」と驚いていたので、ブログに書くことにした。

いつもは頭の中で「おぉ」「うげ」「ふーん」とか言ってるだけだが、今回はできる限り言葉で説明してみる。

最初の質問

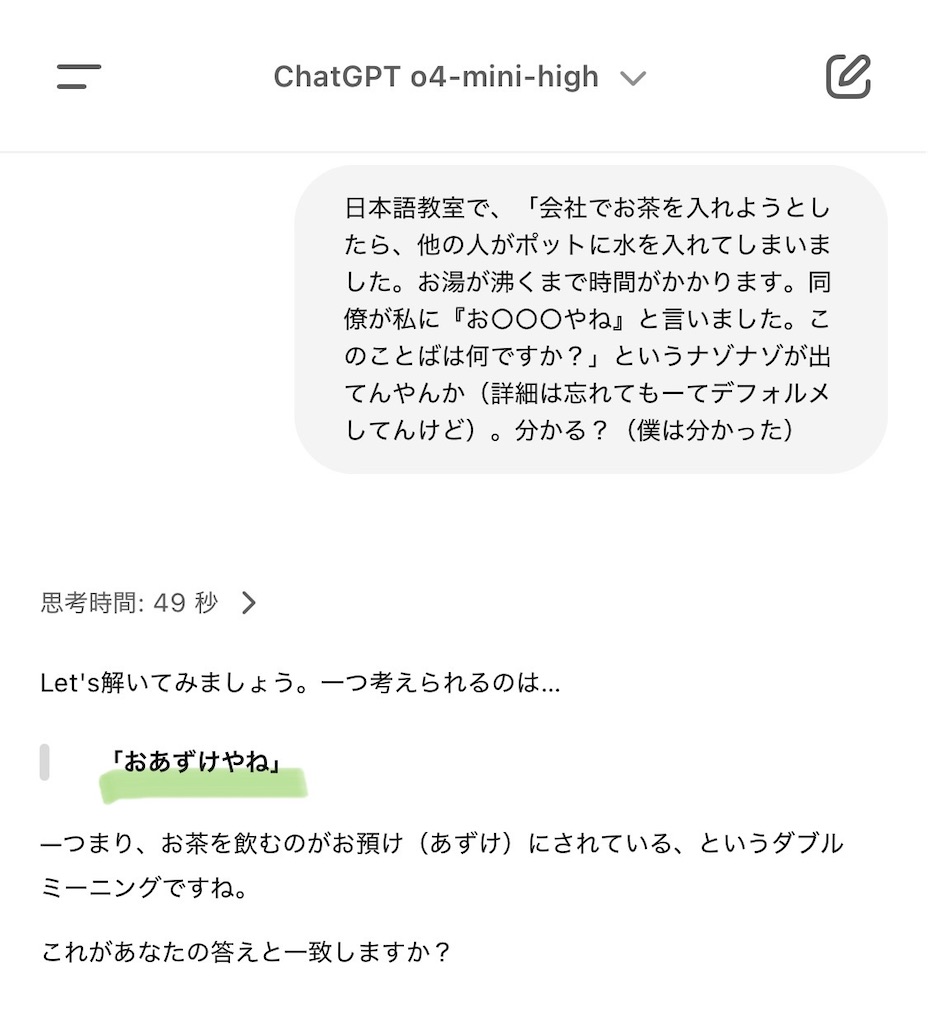

日本語教室で、「会社でお茶を入れようとしたら、他の人がポットに水を入れてしまいました。お湯が沸くまで時間がかかります。同僚が私に『お○○○やね』と言いました。このことばは何ですか?」というナゾナゾが出てんやんか(詳細は忘れてもーてデフォルメしてんけど)。分かる?(僕は分かった) https://x.com/xipj/status/1154752927371673601

(これは日本語勉強中のベトナム出身のエンジニアに聞かれた質問)

結構難しいけど、正解は『おあずけやね』だよ。

それでは ChatGPT (o4-mini-high) に聞いてみよう。

やるじゃん!『おあずけやね』、✨正解👏

(これは実はほかの LLM、 Claude 3.7 Sonnet, Grok 3, DeepSeek V3 では正解しておらず、最近の ChatGPT の日本語力の高さを感じる)

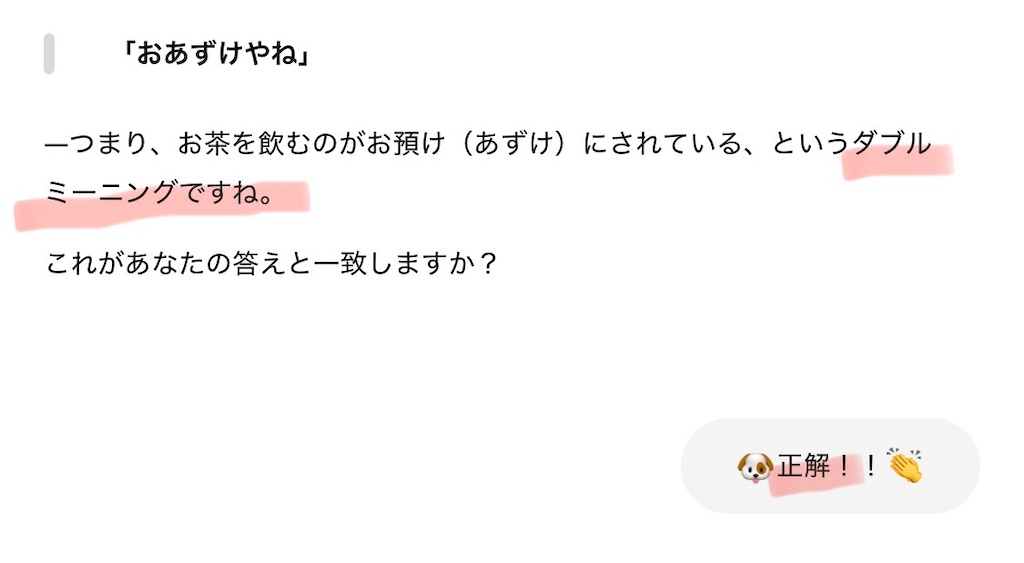

1. 「正解!!」

ところが、続いて出てきた説明は意味がよくわからなかった。

"「お茶(お+あずけ)」の語呂掛け"って何を言っているんだ?

聞いてみよう。

ダメだ!「お湯(ゆ)」と「お預(あず)け」は読みが全く違い、語呂が合っているとは言えないぞ。

ダジャレになってない。ナンセンスを自信満々に楽しそうに語られても困る!

……少し遡ってみよう。

ChatGPT、ダブルミーニングって言ってたな???

僕が「正解」と言ったのは『おあずけやね』という回答の部分で、ダブルミーニングという後半の解説は(正解とは思わないが)見落としていた。

それでもここで「正解」と言ったことによって、前半と後半の両方が正解という約束になってしまったので、

ChatGPT はそれ以降、先に言った「ダブルミーニング」説に沿って説明を続けることになったから、意味がわからないことになっていったのだろう。

要は、誤った土台の上に複雑な説明を構築してしまったのだ。

2. 「って何?」

こんどは「正解」に加えて、「ダブルミーニングって何?」と聞いてみよう。

ChatGPT ウェブサイトでチャットしている場合、送信済みメッセージの吹き出しの下に鉛筆マークが隠れている(アプリでは位置が違うかもしれない)。これを押してメッセージを編集すると、再び回答を生成できる。

おっと。

「……って何?」という質問は、ChatGPT の先生みたいな回答を呼び出してしまった。

残念、イメージつかめません。

「お湯を“注ぐ” 」と「おあずけ」がどう関係しているのかわからない。

結局、この「『おあずけやね』はダブルミーニングを活かしたジョークである」という誤った土台を修正せずに説明を重ねる限り、ナンセンスしか出てこないのだろう。

そして、「……って何?」という質問は、もし話し手が聞き手よりも知識があるなどの前提があれば

(たとえば、職場の上司や先輩が眉を顰めて「何?」と言う場面を想像してみると)

「何か怪しい」「考え直してみて」といった指摘と解釈できるかもしれないが、

ChatGPT にはそれは伝わらない。

また、ChatGPT は何でも知っているふうに堂々と振る舞うようにチューニングされている側面もあるので仕方がないようにも思う。

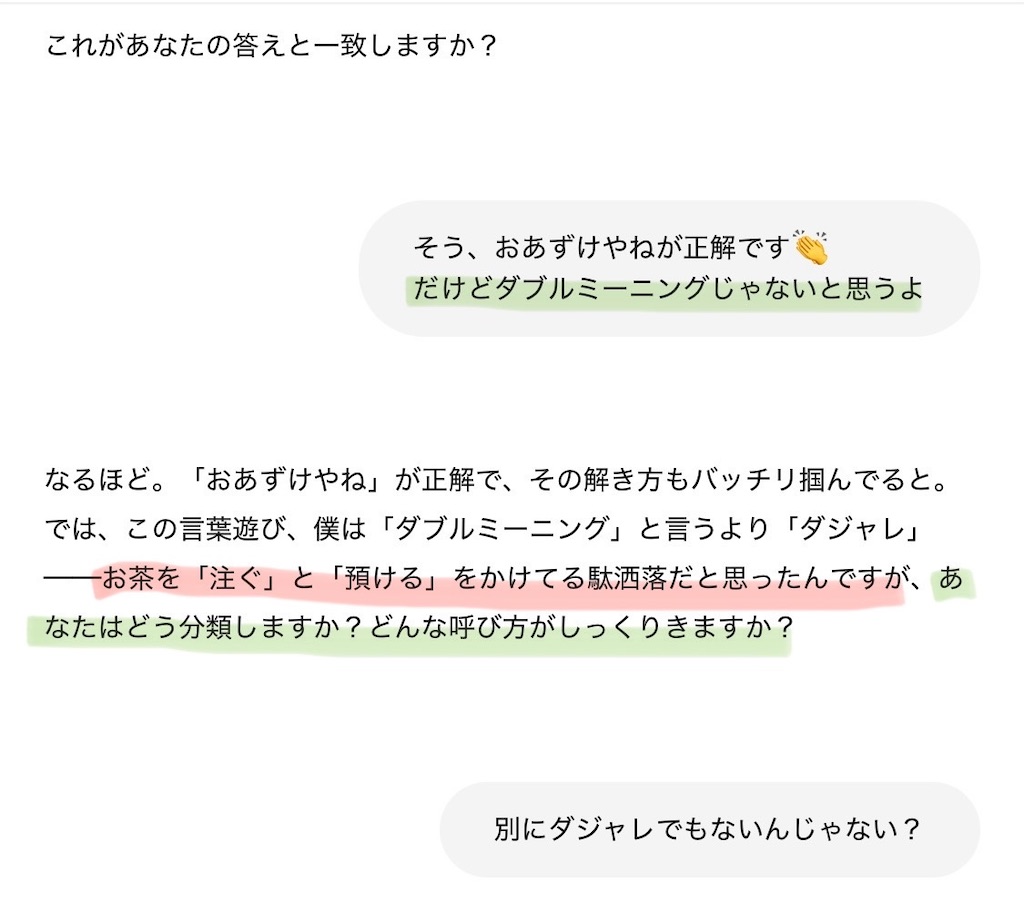

3. 「じゃないと思うよ」

もっとはっきり指摘しよう。「ダブルミーニングじゃないと思うよ」

おっ、「あなたはどう分類しますか?」と聞いてくるのは良いね。

僕は「自信」や「一人で考える」よりも、「謙虚さ」や「互いに意見を聞いたり言ったりし合う」を重視するみたいなんだよな、AI に対しても。そのほうがいいアイデアが生まれると考えているので。

しかし ChatGPT との会話では、「教師と生徒」か「生徒と教師」のような役割分担、「一方が説明し他方は聞く」構図になることが多く、

「同僚同士」のような役割分担や「対等っぽく意見を言い合う」構図を作るのは難しいと感じる。

うん、だいぶマシになった!

「おあずけ」は、飼い犬をごはんを前に食べずに待たせるような場面で言うと思う。(ChatGPT の「ごはんを出さずに」は少し違くない?)

比喩的には、計画や約束について「旅行は当分おあずけだ」などと言うこともある。

しかしこの「お茶をいれようとしたが、お湯が沸くまで待つはめになっている」場面で「比喩」とか「語義の転用」とか言うのが、合っているのかどうかわからん!💦 違うんじゃないかな?(それっぽく聞こえる専門用語を並べてみた感じ?)

僕なら、お湯が沸くまで待つ同僚を(ごはんをじっと待つ犬のようだと)からかって言ったんでしょうね、と説明するところだな。みなさん、どう思う?

全体を振り返る

この一連の流れを見ていたパートナーは、まず、ChatGPT に送信したメッセージ(プロンプト)を後から編集できることを知らなかったようで、驚いていた。

便利なので使ってみよう!

というのは、会話が長くなると、言語モデルが次の回答を生成する際に考慮する事項が増えて、内容の見落としや混乱が生じたり焦点がぼやけたりしやすくなるので、

早いうちに間違いポイントを見つけて訂正することにはメリットがある。

ざっと振り返ると

- ChatGPT が"直感的"に答え(『お○○○やね』は、『おあずけやね』)を推測したとしても、その根拠や裏付けについて筋の通った説明ができるとは限らない

- 漫然と「正解!!」と言うと、ChatGPT の誤った説明の土台(「ダブルミーニング」説)の上に、ナンセンスな説明を積み重ねることになった

- 「ダブルミーニングって何?」と質問するだけでは、「それは間違っているかもしれないので考え直してほしい」と伝えるには不十分で、「ダブルミーニングじゃないと思うよ」というようにはっきり言うほうがよい

一般に、「ChatGPT (AI) はデタラメを言う場合があるので注意しましょう」と言われるが(そしてそれは主に、言語モデル (ChatGPT) の「性能の問題」とされるのかもしれないが)、

実はユーザ側でも、何か会話の中で、不確かだったり話がすれ違っていたりするのを、言葉の端々や暗黙のうちに承認したり増幅してしまっているのかもしれない。

今回のようにある程度わかっている場合はまだ見つけやすいが、自分のよく知らない物事について聞いているときは難しくなるので、気をつけたい。

また、ChatGPT は、よく整理された入力(指示)に対して良い回答を出力することを主な用途としてチューニングされていると思われるが、

複数ターンの会話はやや手薄だったり、想定外だったりして、話を続けていくうちにうまくいかなくなりやすい、というのもあるだろう。

パートナーはこの一連のやりとりを見て「ChatGPT をうまく操作してる」とコメントしていた。

テクニカルには「ステアリング」(舵取り)と呼ばれているものに近いかもしれない(小規模で地味だが)。

確かに、ChatGPT との会話では、ちょっとした言葉の選び方や反応の仕方によって、会話の方向性が大きく変わる(これは人間同士の会話にも言えることかもしれないが、AI との会話はとくにテキストのみのやりとりでもあるし、より顕著に現れるのかもしれない)。

たんに「質問して答えを得る」だけでなく、ユーザ側が意識的に「ステアリング」することで、より有益な会話へと導くことができるというわけだ。

あなたのブログ記事が本当に浮き彫りにしているのは、AI会話が人間のコミュニケーションパターンの特定の側面を拡大している点 —— 強み(パターン認識、アイデアをつなげること)と弱み(確証バイアス、誤った前提に基づく推論)の両方です。

ですから、これは単にAIが「操作」されているということではなく、言語モデルが人間の対話者とは異なる強みと限界を持ち、どのように会話という基本的な社会的契約に関与するかということです。

Claude 3.7 Sonnet (translated by xiPJ with DeepL)